Se utilizan los recientes parches teóricos, metodológicos y nuevos formatos de informes para hacer creer a las/los profesionales de la educación que la información que entrega esta medición tiene utilidad para tomar decisiones pedagógicas en los establecimientos y las aulas. Lo cierto es que se envía un informe 7 meses más tarde a directivos y docentes, con consejos tomados de otras investigaciones, y con números, tendencias, gráficos y agrupaciones que no dicen nada sobre el desempeño individual de los estudiantes. Son solo medias genéricas. Esta información tardía, imprecisa y sin retroalimentación basada en los datos de la medición no permite tomar decisiones pedagógicas. Es de locos.

Preguntas de análisis

En este análisis del último informe SIMCE que llega a directivos y docentes nos preguntamos: ¿Es precisa, oportuna y pertinente la información que recoge el SIMCE o solo una estrategia político-propagandística para legitimarlo? Revisamos las críticas que otros investigadores ya habían planteado con anterioridad. Usamos los criterios propuestos por el National Centre for Vocational Education Research para valorar la calidad de la información que llega a las escuelas y liceos. Y analizamos con ello el informe 2017, el último disponible. Nuestro análisis ha observado que la información que entrega el SIMCE no tiene utilidad pedagógica en el aula ni en los establecimientos y ninguna de las recomendaciones que lleva el informe se basa en los datos de la medición actual. Estas recomendaciones genéricas se extraen de publicaciones académicas previas y no relacionadas con la medición que informan. Desarrollamos esta cuestión con más profundidad. Lee los detalles.

Las primeras críticas a la baja calidad de la información del SIMCE

La baja calidad de la información que entrega el reduccionista y muy costoso sistema de medición no es nueva y ha acompañado al instrumento desde la primera década de la democracia. En 1999, Eyzaguirre y Fontaine (1999), dos académicas de reconocida trayectoria a favor de mantener la prueba SIMCE y profundizar en el uso de puntajes para presionar establecimientos, ya criticaban la baja calidad e inutilidad pedagógica de la medición: «De este estudio se concluye que los progresos (expresados en porcentajes de logro) que se han evidenciado a lo largo de los años de aplicación del SIMCE no son fácilmente interpretables, ya que los niveles de dificultad de la prueba no son absolutos sino variables (es decir, sufren ajustes de acuerdo a la validación experimental que recibe la prueba cada año). A su vez, se advierte que la técnica de construcción de la prueba la hace perder validez de contenido, al bajar demasiado el nivel de dificultad. El análisis del contenido de las pruebas revela que, en promedio, su complejidad corresponde a dos y tres grados menores que el cursado por los alumnos. También queda de manifiesto una falta de coordinación entre las exigencias de básica y media, falencias en la formulación de los ítems y en la selección de las materias». Estos problemas evidentes no evitaron que desde 1995 los resultados se publicasen en los medios y fuesen utilizados a diestra y siniestra para fabricar rankings sin información contextual. El efecto más nocivo ha sido la instalación del mito de la supuesta baja calidad del sistema de educación pública, generando una constante tendencia de migración de la matrícula hacia el sector privado. Con parches o sin parches, el daño social ya está hecho.

Estas críticas fueron mantenidas en silencio y no se mencionaban en los medios por ninguno de los miembros de la pequeña red política-académica que defiende el SIMCE. Sin embargo, fueron consideradas para parchar el instrumento y ampliar y profundizar su uso en el año 2003. Una de las críticas que justificaba esta revisión era que la información que proporcionaba a los profesores y directores no era suficientemente útil como para fundamentar acciones pedagógicas específicas: «En el año 2003 el Ministro de Educación convocó a una comisión de [autodenominados] expertos para hacer un diagnóstico del SIMCE, especialmente de la información que éste proporcionaba y hacer recomendaciones para optimizar su impacto sobre la calidad de la educación. […]Lo que gatilló la decisión del Ministro fue la crítica según la cual el SIMCE no solo estigmatizaba a los establecimientos más pobres, sino que además la información que proporcionaba a los profesores y directores no era suficientemente útil como para fundamentar acciones pedagógicas específicas. […]Entre los aspectos negativos, la Comisión citó el hecho que los resultados reportados a los establecimientos no tenían mayor significado para orientar las prácticas pedagógicas, pues dejan en la oscuridad qué saben o no saben los estudiantes y si los resultados alcanzados son o no suficientes. Asimismo, reconoció que el SIMCE incentivaba prácticas no deseadas de exclusión y selección de alumnos como estrategia para mejorar los resultados, y de concentración de esfuerzos en las generaciones de estudiantes evaluados por este instrumento, en desmedro de las demás» (Ortiz, 2010).

Las supuestas mejoras efectuadas por la comisión se usaron como justificación para implementar más pruebas, medir a más cursos, y se intensificó el uso de los resultados para presionar a través de las políticas oficiales y los medios de comunicación.

¿Por qué estas groseras deficiencias y la baja calidad de la información de uso pedagógico?

El SIMCE no fue originalmente creado para ayudar a mejorar la educación generando datos de calidad. Fue ideado por encargo de la dictadura militar por un equipo de la Pontificia Universidad Católica con el objetivo de dinamizar el mercado educativo y favorecer la incipiente participación de privados, influyendo en la percepción de profesionales, madres y padres. Por ello las pruebas SIMCE nacen como un burdo sistema de visibilización de diferencias sociales y establecimientos a partir de pruebas de papel y lápiz. El instrumento, una tecnología e ideología obsoleta, no fue diseñado para valorar el aporte de cada establecimiento y profesional.

Los parches recientes a una tecnología de medición que se hunde

A partir de 2005, «los resultados comienzan a entregarse en términos de estándares de desempeño, lo que permite desagregar los resultados según el nivel de logro de los estudiantes. […] Los informes fueron modificados para entregar sugerencias a maestros, directivos y padres y apoderados, como también un segundo informe destinado a académicos y autoridades para entregar análisis descriptivos y explicativos de los resultados» (Inzunza y Campos-Martínez, 2016).

Según Carlos Henríquez, ingeniero comercial, secretario ejecutivo de la Agencia de Calidad y ex trabajador del MIDE-UC (una institución que defiende la medición, vende servicios de investigación y medición, y participa en prácticamente todo el sistema de medición educativa en Chile), las pruebas SIMCE han mejorado la información que entregan, ahora se «incorpora reportes por estándares de aprendizaje, habilidad y eje de contenido, además de un informe de errores frecuentes. […] los resultados que hoy se entregan consideran información específica: reportes particulares para sostenedores, directivos, docentes y apoderados. En la misma línea, cada informe de resultados contiene orientaciones de uso de la información» (Carlos Henríquez, en Diario La Tercera). ¿Es esta información de calidad? ¿Qué nivel de profundidad y detalles entrega? ¿Esta información es más o menos rica que la información que ya tienen las escuelas antes de rendir el SIMCE? ¿Se pueden tomar decisiones confiables a partir de los informes SIMCE?

Tomar decisiones basadas en datos: ¿Y si los datos llegan tarde y son imprecisos respecto a los sujetos?

La Agencia de Calidad promueve la toma de decisiones basadas en datos SIMCE, entre otras ideas. Pero ¿estos datos informan la toma de decisiones pedagógica en las aulas y el establecimiento con precisión? En este caso, nos referimos a calidad de los datos para su uso pedagógico, es decir, entendiendo calidad como la relevancia, la precisión y la puntualidad de la información obtenida por la prueba para la toma decisiones relacionadas con las prácticas de enseñanza y para el aprendizaje de los estudiantes, dentro del establecimiento educativo y las aulas.

Para ponderar el valor pedagógico de los datos SIMCE se puede utilizar los criterios propuestos por el National Centre for Vocational Education Research, de Australia, que son los siguientes:

«Principios de calidad de los datos

Los principios de calidad de datos que sustentan los procesos de recopilación de datos de NCVER se alinean con las dimensiones de calidad del Marco de Calidad de Datos de la Oficina de Estadísticas de Australia. Más información sobre las dimensiones de la calidad está disponible en el sitio web de la Oficina de Estadística de Australia.

1. Entorno institucional

Este principio se refiere a los factores institucionales y organizativos que pueden tener una influencia significativa en la eficacia y credibilidad del NCVER en el desarrollo, producción y difusión de estadísticas y publicaciones de investigación. Las cuestiones relacionadas con este principio son la independencia profesional, el mandato de recogida de datos, la adecuación de los recursos, el compromiso de calidad, el secreto estadístico, la imparcialidad y la objetividad.

2. Pertinencia

La pertinencia de la información estadística refleja el grado en que satisface las necesidades de los usuarios. La evaluación de la pertinencia es una cuestión subjetiva que depende de las diversas necesidades de los usuarios. El reto de NCVER es sopesar y equilibrar las necesidades conflictivas de los usuarios actuales y potenciales para producir un programa que vaya lo más lejos posible en la satisfacción de las necesidades más importantes dentro de las limitaciones de recursos dadas. Las cuestiones relacionadas con este principio son el alcance y la cobertura, las clasificaciones y las normas estadísticas, el período de referencia, los detalles geográficos y los conceptos medidos.

3. Oportunidad y puntualidad

La actualidad de la información estadística se refiere al tiempo transcurrido entre el punto de referencia (o el final del período de referencia) al que pertenece la información y la fecha en que la información está disponible. Por lo general, se trata de una compensación contra la precisión. La actualidad de la información influye en su pertinencia.

Los datos deben publicarse de manera oportuna y puntual, con una periodicidad que tenga en cuenta en la mayor medida posible las necesidades de los usuarios. Cuando se considere útil, se pueden publicar resultados preliminares de precisión agregada aceptable.

4. Precisión

La exactitud se refiere al grado en que los datos describen correctamente el fenómeno para el que fueron diseñados. Este es un componente importante de la calidad que tiene implicaciones claras sobre la utilidad y el significado de los datos para la interpretación o el análisis posterior. La exactitud también puede describirse en términos de las principales fuentes de error que potencialmente causan inexactitud (por ejemplo, cobertura, muestreo, falta de respuesta y respuesta).

5. Coherencia y comparabilidad

La coherencia se refiere al grado en que la información estadística puede reunirse con éxito con otra información estadística dentro de un marco analítico amplio y a lo largo del tiempo. El uso de conceptos, clasificaciones y poblaciones objetivo estándar promueve la coherencia, al igual que el uso de una metodología común a través de las colecciones estadísticas. La coherencia no implica necesariamente una coherencia numérica completa, sino más bien una coherencia en los métodos y las normas de recogida.

6. Interpretabilidad

La interpretabilidad de la información estadística se refiere a la disponibilidad de la información suplementaria y los metadatos necesarios para interpretar y utilizar los datos adecuadamente. Esta información abarca normalmente los conceptos subyacentes, las variables y las clasificaciones utilizadas, el alcance, la metodología de la recogida y el tratamiento de datos y las indicaciones de la exactitud de la información estadística.

7. Accesibilidad

La accesibilidad se refiere a la facilidad con la que los usuarios pueden acceder a la información estadística. Esto incluye la facilidad con la que se puede determinar la existencia de información, así como la idoneidad de la forma o medio a través del cual se puede acceder a la información. El costo de la información también puede ser un aspecto de la accesibilidad para algunos usuarios. Los datos deben presentarse de forma clara y comprensible, difundirse de manera adecuada y conveniente, y ponerse a disposición y ser accesibles de forma imparcial, con metadatos y orientaciones de apoyo.»

Con respecto a la toma de decisiones, en los establecimientos encontramos al menos dos niveles de toma de decisiones pedagógicas, el aula, principalmente gobernada por los/las docentes; y el nivel del establecimiento, principalmente gobernado por sostenedores, directores y equipos directivos. Evidentemente, ambos se relacionan y se influyen mutuamente. Nos centraremos en analizar la precisión, la puntualidad y la pertinencia de la información para tomar decisiones en las aulas y en el establecimiento.

Mirando en detalle el informe a directivos y docentes: información imprecisa e impuntual

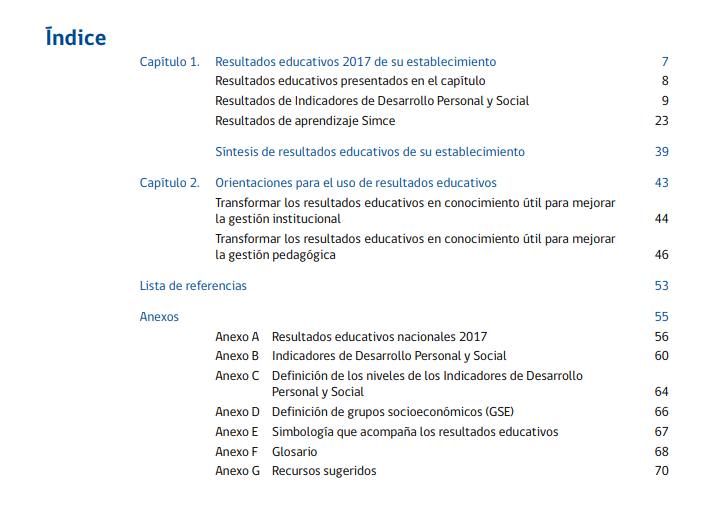

En la imagen, se observa el índice del último informe de resultados enviado a un establecimiento.

Al revisarlo en detalle, se aprecia que la información entregada por el SIMCE es inútil, por si sola, para la toma de decisiones en las aulas y los establecimientos, por varias razones.

Razón 1: La información que entrega es imprecisa en relación a los sujetos (las/los estudiantes); pues solo se entregan desagregados por curso y corresponden a medias y distribuciones en niveles de desempeño respecto a un estándar genérico. Si se toman decisiones pedagógicas utilizando estos datos, ¿a quién se aplican estas decisiones si no se puede establecer una relación entre dato y sujeto (estudiante)?

Razón 2: Este informe es impuntual, porque llega a destiempo y no permite acciones remediales oportunas, entre seis y siete meses entre la toma de datos y llegada del folleto de informe, en el mejor de los casos. En el mejor de los casos con la información SIMCE se toman decisiones generales y obvias, y se aplican a cursos anteriores (no al curso medido, que ya no será considerado en la siguiente medición). La lentitud de la medición estandarizada hace que su información llegue tarde, porque no han sido diseñadas para eso.

Razón 3: Carece de pertinencia, la información que generan las propias escuelas y liceos es suficiente por sí sola. Aunque la Agencia en su propaganda 2018 habla de la importancia del SIMCE para la toma de decisiones pedagógicas y atribuye a esta medición capacidades milagrosas que no tiene, en el informe el panorama es bien distinto. En el documento que llega a las Escuelas y Liceos se limita a expresar que «se espera que esta información contribuya a la toma de decisiones institucionales que se plasman en el Proyecto Educativo Institucional (PEI) y en el Plan de Mejoramiento Educativo (PME). El objetivo es aportar al ciclo de mejoramiento continuo de su establecimiento, de modo que el proceso de desarrollo personal, social y académico de los estudiantes se fortalezca año a año» (Resultados Educativos. Educación Media. Docentes y Directivos Informe 2017). No se menciona la toma de decisiones en el aula por ninguna parte. Esta afirmación explícita de la Agencia, plasmar los resultados en el PEI y PME, nos permite decir que se busca que el puntaje SIMCE se transforme en una meta educativa explícita del establecimiento. No es de extrañar que el uso principal del SIMCE esté siendo el de fijar metas de forma acrítica, sin detenerse a pensar sobre el empobrecimiento curricular que conlleva fijar metas en términos de puntajes numéricos en las pocas asignaturas que mide el SIMCE. Este uso del puntaje como objetivo educativo reduccionista, se observa en los convenios de desempeño de directores, en los PEI, PME y en las compras públicas de los establecimientos.

El propio informe de resultados a directivos y docentes, con un tamaño de letra pequeño, deja claro que el instrumento de medición tiene nula utilidad sin la información que generan las escuelas. Por ejemplo, se dice en el informe que no es correcto que se utilice los puntajes de los Indicadores de Desarrollo Personal y Social (IDPS) para «Establecer conclusiones sin considerar los resultados educativos en conjunto». También se agrega: «No es correcto que utilice la distribución de las respuestas en cada nivel de los IDPS para: Establecer equivalencia entre este porcentaje y la cantidad de estudiantes, Comparar la distribución de su escuela entre indicadores, Comparar la distribución con la de la evaluación anterior». ¿Para qué sirve el puntaje en las aulas y los establecimientos, entonces?

Similar recomendación encontramos en los resultados académicos. En el informe se dice: «No es correcto que utilice los puntajes promedio para: Comparar los puntajes de cada año sin considerar el símbolo que acompaña al dato; Comparar el resultado del primer año de la tendencia con el del último para establecer una brecha entre ellos, porque puede haber error de estimación en este cálculo; Comparar resultados entre asignaturas o promediar las asignaturas de un mismo grado; Emitir juicios sobre los estudiantes o los profesores». ¿Para qué sirve el puntaje en las aulas y los establecimientos, entonces?

Razón 4: Las recomendaciones genéricas en el informe se obtienen de publicaciones académicas previas y no se basan en el análisis de los datos que informan. La información que entrega el informe SIMCE no tiene utilidad pedagógica en el aula ni en los establecimientos. Ninguna de las recomendaciones que lleva el informe se basa en los datos de la medición actual. Se extraen de otras publicaciones académicas. Cita textual de ejemplo contenida en el último informe a Directivos y Docentes: «A continuación se presentan algunas recomendaciones generales respecto de las evaluaciones en aula […]»(Resultados Educativos. Educación Media. Docentes y Directivos Informe 2017), recomendaciones que han sido extraídas de Hamilton, L., Mandinach, E., Supovitz, J., y Wayan, J., 2009 [adaptación] (ver imagen, captura de informe real).

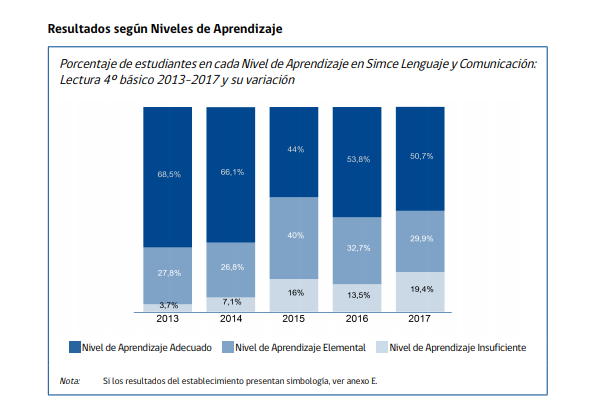

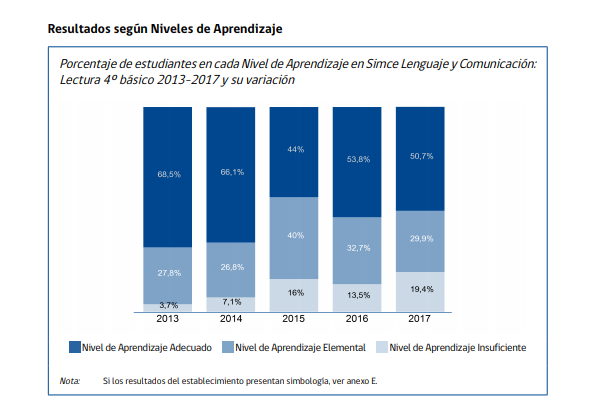

El argumento de la utilidad pedagógica del SIMCE para tomar decisiones a nivel del aula y del establecimiento es totalmente falaz. No se sustenta si se analiza el tipo de información entregada, principalmente medias de puntaje de cursos, agrupaciones dentro de los niveles de desempeño y tendencias. Por ejemplo, la imagen siguiente muestra una captura de un informe real sobre los resultados 2017. La información es imprecisa, porque no se puede relacionar con los sujetos (estudiantes). No es pertinente, pues no ayuda a solucionar las necesidades de los docentes para la toma de decisiones pedagógicas. Por ejemplo, no aporta datos para responder a la pregunta: ¿quiénes son los estudiantes del curso X que requieren más apoyo? ¿Quiénes son los estudiantes del curso X que están en el nivel más bajo de desempeño? ¿Quiénes son los estudiantes del curso X que no han logrado el eje de habilidad Y? Los establecimientos tienen que adivinar o usar sus propios datos para tomar decisiones pedagógicas con sentido en el aula o el establecimiento. Los que entrega el SIMCE no informan ninguna medida remedial que se quiera aplicar.

El propio informe reconoce esta grave limitación de manera tácita en las recomendaciones para el uso de datos que propone. Allí se lee que es necesario «realizar inicialmente un diagnóstico en relación al propio uso, manejo y análisis de datos al interior de la escuela» Las comunidades educativas tienen las capacidades para evaluar con mayor oportunidad, precisión y pertinencia que el costoso SIMCE. Y si no las tienen, se pueden capacitar a través de asesoramiento.

Comentarios finales

El problema del SIMCE no es solo puntual de la prueba. Es una limitación de la ideología de la medición educativa y de la responsabilización de resultados en su conjunto: «Cuando las medidas del rendimiento sirven como criterio principal para el juicio sobre la eficacia educativa en los sistemas de rendición de cuentas, se requiere algún nivel de evidencia que muestre una relación defendible entre las puntuaciones de un test y la calidad de la instrucción o de otras experiencias educativas ofrecidas en la escuela.

A menos que exista una vinculación causal entre ambas, el uso de tales tests como medidas dependientes oscila entre lo cuestionable y lo no garantizado.La dirección de la vinculación no es que las pruebas estén diseñadas para adaptarse a la instrucción, sino más bien que los objetivos estimulen actividades instructivas apropiadas y el aprendizaje consecuente sea «muestreado» por el test. Este mapa de objetivos para la instrucción y para la evaluación es lo que se supone debe ser la alineación entre currículo y evaluación (Baker, 2005), pero es difícil de desarrollar completamente […]» (Baker, 2009:95-96).

Ya en 2014, en el marco de un investigación, un director le decía a uno de los padres del SIMCE, el académico Jorge Manzi, que esta medición externa era innecesaria: «Yo […] no creo en informaciones externas. […] Pienso que tenemos la capacidad para detectar, identificar y reconocer aquellos tópicos en lo cual los alumnos están fallando. (E8, Bajo-Bajo) (Manzi, Bogolasky, Gutiérrez, Grau y Volante, 2014: 65).

Referencias

Baker, E. (2009) Consideraciones de validez prioritaria para la evaluación formativa y de rendición de cuentas. Revista de Educación, 348. Enero-abril 2009, pp. 91-109.

Eyzaguirre, B y Fontaine, L. (1999).“¿Qué mide realmente el SIMCE?”, Estudios Públicos, 75, pp. 107-161.

Inzunza, J. y Campos-Martínez, J. (2016). El SIMCE en Chile: Historia, Problematización y Resistencia. En XI SEMINARIO INTERNACIONAL DE LA RED ESTRADO: Movimientos Pedagógicos y Trabajo Docente en tiempos de estandarización. México.

Manzi, J., Bogolasky, F. , Gutiérrez, G., Grau, V. y Volante, P. (2014) Análisis sobre valoraciones, comprensión y uso del SIMCE por parte de directores escolares de establecimientos subvencionados. Proyecto FONIDE N°: F711269

Ortiz, I. (2010). 25 años del SIMCE. Centro de Investigación y Desarrollo de La Educación (CIDE). Recuperado de http://mailing.uahurtado.cl/cuaderno_educacion_25/pdf/ARTICULO_25.pdf

Miguel Stuardo Concha es profesor e investigador actualmente vinculado a la Universidad CY Cergy París, como director de la formación Licencia Profesional Trilingüe Comercio ecoresponsable y desarrollo sustentable. Doctor en Educación y Máster en Calidad y Mejora de La Educación por La Universidad Autónoma de Madrid (UAM). Profesor de Castellano y Comunicación y Licenciado en Educación en la Universidad de La Frontera, Chile. Investiga sobre eco-responsabilidad, mejora escolar, educación y justicia social, acogida de estudiantes migrantes, investigación libre y abierta y enseñanza del español como segunda lengua.

Deja una respuesta